The following paper was generated as accompanying material for the seminar

“multimedia in space”.

In the context of this paper the history of astronautics and its technical developments

in reference to computer science will be shown. Basically some systems, which

are able to fulfil their tasks independently, will be specified. For that different

satellites, which regard the earth, and the Hubble space telescope, that is

observing the aerospace, are presented in this paper.

To give an review of different satellite systems the tasks of some active remote

sensing satellites like the Quickbird satellite will be described. Furthermore

the both mars missions of NASA and ESA are compared, searching some similarities

and differences.

Der Weltraum übte schon auf frühste Zivilisationen große Faszination

aus. Die Konstellation der Sterne prägte das Weltbild verschiedener Kulturen

und spielte im Leben der Menschen immer eine große Rolle. Schon im alten

Ägypten stand das Interesse, den Himmel berechenbar zu machen, im Vordergrund.

Im 16. bzw. 17. Jahrhundert bemühten sich unter anderem die Astronomen

Galileo Galilei, Nikolaus Kopernikus und Johannes Keppler ihr Wissen über

unser Universum zu erweitern. Jedoch erst im 20. Jahrhundert gelang es der Menschheit,

die Phänomene des Weltraums hautnah mitzuerleben.

Mit immer neuer Technik versucht der Mensch auch die letzten Geheimnisse zu

lösen. Dabei bezieht er sich nicht nur auf den Weltraum. Noch heute werden

Inseln auf der Erde mittels neuester Fernerkundungssatelliten entdeckt, die

bis dato auf keiner Landkarte verzeichnet sind.

Trotz dieser Entdeckungen richtet sich das Hauptaugenmerk der Menschheit auf

das Weltall. Es gibt so viele Dinge die der Mensch noch nicht verstehen kann.

Die Möglichkeiten, die die neueste Technik uns näher bringt, sind

für jeden faszinierend. Gerade in Zeiten, in der die Angst vor Terror allgegenwärtig

ist, sehnt man sich danach einfach ins Weltall fliegen zu können, um eine

kurze Auszeit zu bekommen. Wenn man die Entwicklung der Erforschung des Weltalls

betrachtet, erkennt man schnell, dass die Menschheit trotz jahrtausend langer

Beobachtung doch erst noch am Anfang steht.

Und da kommt wieder die Technik ins Spiel. Sie hilft uns bei der Aufklärung

unsere Fragen. Sei es das Hubble Teleskop, das trotz seine anfänglichen

Probleme, die Reichweite des menschlichen Auges in Gebiete befördert hat,

die noch nie ein Mensch zuvor gesehen hat. Oder unser geheimnisvoller Nachbarplanet,

der gerade im Moment eine so große Anziehungskraft auf uns ausübt,

so dass die NASA und die ESA gleichzeitig eine Armada von technischen Geräten

in seine Richtung entsendet haben um zu klären, ob es Leben auf dem Mars

gab, und ob noch heute Leben auf ihm möglich ist.

Um genau diese technischen Geräte geht es in diesem Seminar. Die vorliegende

Ausarbeitung soll einen Einblick über den momentanen Stand der Entwicklung

geben. Dabei wird nicht nur auf das Hubble Teleskop und die Marsmissionen eingegangen,

sondern auch auf die geschichtliche Entwicklung der Raumfahrt und auf Fernerkundungssatelliten.

Seit 1942 gilt Peenemünde auf der Insel Usedom weltweit als Geburtsstätte der modernen Raumfahrt. Unmittelbar damit verbunden ist die sogenannte Wunderwaffe V2. Die als Waffe entwickelte Rakete tötete während des Zweiten Weltkrieges ab 1944 tausende Menschen in Großbritannien, Frankreich und Belgien. Die Tatsache, dass die V2 zur Vernichtung von Menschen entwickelt wurde, macht es schwer die Ingenieursleistung von Wernher von Braun wertfrei zu würdigen. Die V2 erreichte in der Testphase eine Flughöhe von etwa 90 km und eine Schubleistung von 25000 kg.

Als am 4. Oktober 1957 die Sowjets den ersten Satelliten mit dem Namen „Sputnik

1“ starteten, löste das bei den Amerikanern eine große Unruhe

aus, da es sich bei der Trägerrakete von „Sputnik 1“ um die

erste Interkontinentalrakete der Welt handelte. Die Sowjets wären somit

in der Lage gewesen, in wenigen Minuten eine Atombombe nach Amerika zu schicken,

was ihnen den strategisch wichtigen Erstschlag ermöglicht hätte .

Sputnik 1 war eine Wissenschaftssatellit, mit dem z.B. die Elektronendichte

der Ionosphäre und die Ausbreitung der elektrischen Wellen gemessen werden

sollte. Er hatte ein Gewicht von 80 kg und die Form einer Kugel. Die Außenhülle

bestand aus Aluminium, damit man ihn von der Erde aus erkennen konnte, wenn

er vom Sonnenlicht angestrahlt wurde.

Die Übermittlung der Daten erfolgte über die Frequenzen 20,005 und

40,002 MHz, wobei die Batterien eine Leistung von 1 Watt abgaben. Zusätzlich

sendete ein kleiner Radiosender ein „Biep-Signal“, das auf der ganzen

Welt empfangen werden konnte.

Die anfängliche Flugbahn von Sputnik 1 verlief zwischen 228 km im erdnächsten

und 947 km im erdfernsten Punkt, die sich später auf 200 km verminderte,

bis er nach 92 Tagen in der Erdatmosphäre verglühte.

Sputnik 1 bildete den Auftakt zum Wettlauf um die Vorherrschaft im Weltall zwischen

der USA und der Sowjetunion.

Am 2.11.1957 wurde mit „Sputnik 2“ das erste Lebewesen ins Weltall

geschickt. Als tierischer Astronaut wurde die Hündin „Lajka“

ausgewählt, die wegen der enormen Hitze nach nur wenigen Umrundungen verendete.

Das Gewicht von „Sputnik 2“ war auf über 500 kg angestiegen.

Die Hündin „Lajka“ war nicht das erste und letzte Tier, welches

in den Weltraum geschossen wurde und dabei sein Leben verlor.

Im Jahr 1958 wurde die National Aeronautics and Space Administration, kurz NASA, als direkter Nachfolger des National Advisory Commitee for Aeronautics (NACA) gegründet. Die Gründung der NASA ging auf den Schock zurück, der vom Start von „Sputnik 1“ in den USA verursacht wurde. Durch die Aktivität der NASA wurde eine klare Trennung zwischen militärischen und zivilen Weltraumprogrammen geschaffen.

Am 31.Januar 1958 wurde der erste Satellit der USA mit dem Namen Explorer in

den Weltraum mittels einer Trägerrakete transportiert, die unter anderem

von Wernher von Braun entwickelt wurde. Der berühmte Forscher Wernher von

Braun war nach dem Krieg von den Amerikanern mit in die Staaten beordert worden,

wo er seine Entwicklungen fortsetzen musste.

Der Explorer Satellit war auch wissenschaftlich bedeutend, da dieser mit seinem

Geigerzähler den Van-Allen Strahlungsgürtel entdeckte.

Lunika 3 wurde durch Funksignale von der Erde aus kontrolliert. Er umkreiste den Mond in einer Entfernung von 6.200 km, während die Rückseite von der Sonne beleuchtet war. Am 7. Oktober 1959 nahm das Kamerasystem insgesamt 29 Bilder auf, die ca. 70% der Oberfläche darstellten. Die Bilder wurden an Bord entwickelt und gescannt. Am 18. Oktober 1959 wurden 17 Bilder zur Erde übermittelt. Obwohl die Aufnahmen sehr unscharf waren, dienten sie trotzdem zur Herstellung eines ersten Atlas der Mondrückseite. Neben bergigen Oberflächen wurden zwei große dunkle Regionen entdeckt: das Mare Moscovrae und das Mare Desiderii.

Am 12.April 1961 überraschen die Sowjets die Amerikaner erneut, in dem sie den ersten Menschen mit einer Wostok Rakete ins Weltall schickten. Major Juri Alexejewitsch Gagarin umkreiste als erster Mann ca. neunundachtzig Minuten lang die Erde, bevor er wieder unbeschadet auf der Erde landete. Die Amerikaner mussten durch dieses Ereignis den zweiten schweren Schlag im Wettlauf um die Erforschung des Weltalls hinnehmen.

Obwohl die Amerikaner diese Etappe der Raumfahrtgeschichte verloren haben,

schicken sie am 5.Mai 1961, nur einen Monat nach Gagarins Weltraumflug, Alan

Shepard ins Weltall.

Er verbracht in seiner Raumkapsel "Freedom 7" nur etwa fünfzehn

Minuten im Weltall, bevor er wieder zur Erde zurückkehrte. 1971 wurde Alan

Shepard Kommandant von Apollo 14 und verbrachte 9 Stunden auf der Mondoberfläche.

Dadurch, dass die Sowjets den ersten Satelliten und den ersten Menschen ins Weltall geschickt hatten, fühlten sich die Amerikaner sehr in die Enge gedrängt. Deswegen verkündete Präsident J.F. Kennedy am 25.Mai 1961, dass die NASA bis zum Ende des Jahrzehnts eine Mondlandung durchführen wird. Ab diesem Zeitpunkt startet das Wettrennen zwischen der USA und der Sowjetunion um die Erkundung des Mondes.

Am 20.Februar 1962 umkreist John Glenn als erster Amerikaner die Erde (nachdem

Alan Shepard sich nur kurz im Weltall aufgehalten hatte.)

John Glenn wurde im Januar 1998 im Alter von 77 Jahren noch einmal am Bord der

Raumfähre Discovery in den Weltraum geschickt. Es sollte erforscht werden,

wie sich die Schwerelosigkeit auf den Körper von älteren Menschen

auswirkt.

Mit dem Kosmonauten Alexej Leonow brachten die Sowjets am 18.März 1965 den ersten Menschen ins All, der sein Raumfahrzeug verließ und nur mit einer Sicherheitsleine gesichert ca. zehn Minuten lang frei im Weltraum schwebte.

Im Dezember 1968 ging ein wenig glanzvolles Jahr für die USA, nachdem

Martin Luther King und Robert Kennedy ermordet wurden und massive Demonstrationen

gegen den Vietnamkrieg stattfanden, zu Ende.

Der 24. und der 25. Dezember ließen das Jahr nicht ganz so negativ erscheinen,

da die Amerikaner gegenüber den Sowjets weiter aufholen im Wettlauf um

das Weltall. Mit Apollo 8 umkreist das erste bemannte Raumfahrzeug den Mond.

Rund acht Jahre nachdem J.F. Kennedy das Apollo-Programm ins Leben gerufen

hat, war der Mond für Neil Armstrong und Edwin Aldrin in greifbarer Nähe.

Nach etwa 109 Stunden nach dem Start von Apollo 11 setzt Neil Armstrong seine

Fuß auf die Oberfläche des Mondes und sagt wohl einen der bekanntesten

Sätze in der Geschichte der Menschheit

„That is one small step for a man, one giant leap for mankind.”

Edwin Aldrin betrat als zweiter Mensch den Mond, während Neil Armstrong

eine Fernsehkamera aufbaute, mit der die Erde visuellen Kontakt zu den beiden

hatte. Die beiden Astronauten führten zunächst einige Tests durch

und sammelten Gesteinsproben vom Mond ein, bevor sie nach etwa 2 Stunden und

25 Minuten wieder zur Mondfähre zurück kehrte. Sie flogen zurück

zum Mutterschiff, indem Michael Collins die ganze Zeit um den Mond kreiste.

Die drei Astronauten kamen als Helden auf die Erde zurück, und die Amerikaner

hatten durch die Mondlandung die Sowjets im Wettlauf um das Weltall überholt.

Seit dem 21.Juli 1969 gibt es viele Menschen, die daran zweifeln, dass die Mondlandung

tatsächlich statt gefunden hat. Sie vermuten, dass alles von der NASA irgendwo

auf der Erde inszeniert wurde. So sind z.B. keine Sterne im Hintergrund zu sehen,

oder es gibt verschiedene Schatten von mehreren Lichtquellen. Die NASA streitet

natürlich alles ab, aber ob es nicht doch ein Trick war, kann man bis zum

heutigen Zeitpunkt nicht genau sagen.

Die Raumstation Saljut 1 wurde am 19. April 1971 in eine relativ niedrige Umlaufbahn

gebracht. Die Station war fast 16 Meter lang und wog etwa 19 Tonnen. Nachdem

die Kopplung von Saljut 1 und der Mission Sojus 10 nicht gelang, wurde dieser

Versuch abgebrochen. Im Juni 1971 folgte ein weiterer Versuch, bei der die Kopplung

funktionierte. Die drei Kosmonauten Dobrowolskij, Patsajew und Wolkow verblieben

und arbeiteten 23 Tage in der Station bis sie auf dem Heimflug mit ihrer Sojuskapsel

beim Wiedereintritt in die Erdatmosphäre auf tragische Weise durch einen

Defekt eines Druckausgleichsventils ums Leben kamen.

Die Station verglühte nach etwa einem halben Jahr Flugzeit am 11. Oktober

1971 in der Erdatmosphäre.

Die amerikanische Raumstation Skylab wurde am 14.Mai 1973 in eine Umlaufbahn

um die Erde gebracht. Von 1973 bis 1974 wurde Skylab von insgesamt neun Astronauten

( drei Mannschaften mit 3 Astronauten) besetzt. Sie führten astrophysikalische

Untersuchungen und Sonnenbeobachtungen durch. Außerdem unternahm die Besatzung

Experimente, um die Auswirkung der Schwerelosigkeit auf den Menschen während

eines Weltraumaufenthalts zu untersuchen.

1979 verglühte die Station programmgemäß, nachdem sie im Orbit

an Höhe verloren hatte.

Am 17.Juli 1975 koppelten eine Apollo und eine Sojus-Kapsel an einander an, so das sich die Kosmonauten Alexij Leonow und Walerij Kubasow und die Astronauten Thomas Stafford, Deke Slayton und Vance Brand im Weltall trafen. Dieses Ereignis war aus technischer Sicht keine Herausforderung, aber aus weltpolitischer ein Wunder. Dieses Rendezvous war trotzdem zwei Jahrzehnte lang einmalig, und hat darum einen hohen Stellenwert in der Geschichte des „Kalten Krieges“.

Am 20. Juli 1977 ereichte die Sonde Viking 1 den Mars und am 3. September 1977 die Sonde Viking 2. Die Viking-Lander waren die bis dahin erfolgreichsten Marsmissionen. Sie sendeten Panoramabilder von der Marsoberfläche und führten Bodenproben durch. Anhand dessen, konnten die NASA -Wissenschaftler der Menschheit mitteilen, dass es kein Leben auf dem Mars gibt.

Die Voyager-Missionen waren wohl die erfolgreichsten Missionen in der Geschichte

der Raumfahrt. Voyager 1 hatte die Aufgabe die Planeten Jupiter und Saturn mit

ihren Monden zu erkunden und Voyager 2 folgte ihr und erkundete zusätzlich

noch den Uranus (erst 1986) und den Saturn.(erst 1989). Die beiden Sonden befinden

sich nach Schätzungen zur Zeit außerhalb unseres Sonnensystems.

Als zusätzliche Aufgabe führen die Voyager-Sonden eine gold-schimmernde

"Schallplatte" mit sich, die "Sound of Earth" genannt wird.

Auf diesen Platten sind Grußbotschaften der Menschen mit Bildern und Geräuschen

unseres Planeten vorhanden, um eventuellen fremden Intelligenzen, die auf die

Sonde stoßen sollten, zu offenbaren, woher dieser "Reisende"

kommt.

SpaceLab war das erste europäische Weltraumlabor, das am 28. November

mit Hilfe von einem amerikanischen Space Shuttle in eine Erdumlaufbahn gebracht

wurde.

Es wurde für medizinische Forschungen, Erdbeobachtungen sowie für

biologische, technische und physikalische Experimente benutzt. Seit 2000 wird

es als Trainingseinheit und Vorbereitung für Experimente im All genutzt.

Am 28.Januar 1986 explodierte die Trägerrakete samt dem Space Shuttle Challenger nur 73 Sekunden nach dem Start. Bei diesem Unfall starben sechs Astronauten und eine Lehrerin. Die Lehrerin Christa McAuliffe war mit an Bord der Challenger um ihre Schulklasse aus dem Weltall zu unterrichten.

Am 20. Februar 1986 wurde das Basismodul der MIR in das Weltall gebracht. Trotz

des Zusammenbruchs der Sowjetunion und der Finanzprobleme des Landes wurde die

Endkonfiguration der MIR mit dem Start des Moduls Piroda am 23. April 1996 vollendet.

Die MIR dient für viele Experimente als Raumstation, aber die Probleme

durch Pannen und kleine Katastrophen nahmen im Laufe der Zeit zu.

Der Rover Sojourner der Pathfinder-Mission galt als Generalprobe für die Mars Exploration Rover. Die aus der Pathfinder-Mission gewonnenen Informationen wurden in der Entwicklung und Ausarbeitung der Mars Exploration Rover Mission verwendet. Die Pathfinder-Sonde schickte über 16500 Fotos zur Erde und Sojouner schickte über 500 Fotos sowie Analysewerte von 16 Untersuchungsobjekten.

Schon im Jahr 1984 kurz nach der SkyLab Mission kündigt US Präsident

R. Reagan an einer weiteren amerikanischen Raumstation zu bauen. Schon zu diesem

Zeitpunkt lud er andere Staaten zur Zusammenarbeit ein. Kanada, Europa, Japan

und später auch Russland folgten dieser Einladung und wollten an der auf

„Freedom“ getauften Station mitarbeiten.

Am 20. November 1998 wurde das erste Modul der Internationalen Raumstation ISS

dann mit einer russischen Trägerrakete in seine Umlaufbahn gebracht.

Nach 13 Jahren kehren die letzten Kosmonauten von der Raumstation MIR auf die Erde zurück.

Am 23.März 2001 wurde die MIR kontrolliert zum Absturz gebracht. Die Teile, die nicht beim Eintritt in die Erdatmosphäre verglühen stürzen in ein unbewohntest, Gebiet im Südpazifik. Die Ära MIR ist nach 15 Jahren zu Ende.

Die erste ständige Besatzung besteht aus dem Amerikaner Bill Shepherd

und seinen beiden russischen Kollegen Jurji Gidzenko und Sergej Krikalew. Diese

treffen Anfang November auf der ISS ein.

Im folgenden Kapitel sollen verschiedene Arten von Satelliten, ihr Aufbau, ihre Aufgaben und die verschiedenen Umlaufbahnen vorgestellt werden. Das Hauptaugenmerk wird hierbei auf Fernerkundungssatelliten gelegt. Um einen Überblick über den momentanen Stand der Technik zu geben, werden die Systeme Spot, Ikonos und Quickbird als Bespiele herangezogen.

Seit „Sputnik 1“ gibt es eine Vielzahl von Satelliten, die die

verschiedensten Aufgaben erledigen. Auch die Satellitentechnik hat sich verbessert.

Es gibt zur Zeit spezielle Studiengänge, die sich mit der Entwicklung von

neuen Satelliten beschäftigen. Ein Leben ohne Satelliten wäre für

die moderne Zivilisation nicht mehr denkbar.

So werden z.B. fast alle Fernsehkanäle über Satelliten übertragen,

wobei es keine Rolle spielt ob man eine eigene Satellitenanlage besitzt, oder

sein Fernsehprogramm über Kabel bekommt.

Es gibt um die Erde herum verschieden Umlaufbahnen, auf denen sich die Satelliten befinden. Jede dieser Umlaufbahnen hat verschiedene Eigenschaften, d.h. die Satelliten bewegen sich von der Sicht der Erde aus verschieden. Während einige still zu stehen scheinen, fliegen andere über uns hinweg und kehren erst nach einiger Zeit zurück.

Satelliten, die sich in der geostationären Umlaufbahn befinden, haben

eine Flughöhe von ca. 36000 km und befinden sich direkt oberhalb des Äquators.

Sie haben eine feste Position, da sich immer über dem gleichen Gebiet auf

der Erde befindet. Aus diesem Grund werden sie für die Rundfunk- und Fernsehübertragung

genutzt. Sie sind jedoch im Vergleich zu anderen Satelliten sehr groß

und teuer.

Bei der Übertragung von Signalen eines geostationären Satelliten zur

Erde kommt es zu einer Verzögerung von einer Viertelsekunde.

Satelliten die sich in einer mittleren Erdumlaufbahn befinden, fliegen in einer

Höhe von ca. 9.600 km und mehr um die Erde.

Um eine flächendeckende Versorgung der Erde zu erreichen, sind zwei Dutzend

Satelliten in der mittleren Bahn notwendig. Sende- und Empfangsgeräte brauchen

für die Übertragung von Daten zu den MEO-Satelliten relativ viel Energie.

Die LEO-Satelliten haben eine Flughöhe von 600 bis 1.600 km und sind am

häufigsten im Weltall vertreten.

Sie sind besonders klein, leicht und günstig. Durch die geringe Entfernung

zur Erde, kommt es zu keiner Signalverzögerung. Außerdem benötigen

die Endgeräte wenig Energie, so dass diese Satelliten-Systeme sehr gut

für Satelliten-Telephonie geeignet sind.

Satelliten bestehen aus einer Vielzahl von Instrumenten, die sich je nach Aufgabengebiet unterscheiden. Heute gibt es spezielle Studiengänge, die sich mit der Nutzlast von Satelliten beschäftigen. Im Folgenden soll deshalb nur ein grober Einblick in die Bestandteile eines Satelliten gegeben werden.

Damit ein Satellit zu jeder Zeit mit der benötigten Energie versorgt wird,

befindet sich an Bord das sogenannte EPS ( zu deutsch: Stromversorgungseinheit).

Das EPS steuert also die Verteilung und den Verbrauch der an Bord eines Satelliten

befindlichen Energie.

Die hauptsächliche Energie gewinnt ein Satellit durch seine Solarsegel,

mit denen die Sonnenenergie in elektrische Energie umgewandelt wird, um somit

die sich an Bord befindlichen Batterien aufzuladen. Befindet sich der Satellit

nicht im Strahlungsbereich der Sonne, greift er automatisch auf die gespeicherte

Energie in den Batterien zurück, um so sicher zu stellen, dass alle Bauteile

mit genügend Strom versorgt werden.

Mit Hilfe der Positions- und Orbit-Kontrolleinheit (AOCS) wird permanent die

Position eines Satelliten ermittelt und gesteuert. Dadurch wird er während

der gesamten Mission in der gewünschten Position gehalten.

Soll die Position geändert werden, werden die sogenannten Whells eingesetzt,

die in der Lage sind, den Satelliten um drei Achsen zu bewegen. Um den Orbit

zu wechseln, benötigt man die Düsen (Thruster) oder das Haupttriebwerk,

welches aber nicht zwangsläufig in jedem Satelliten benötigt wird.

Änderungen der Position oder des Orbits können vom Satelliten automatisch

oder von der Bodenkontrolle aus durchgeführt werden. Die Bodenkontrolle

erhält die Daten in Form von Telemetry vom Satelliten.

Das OBDH ist die Hauptsteuereinheit eines jeden Satelliten. Sie verarbeitet alle internen und externen Daten. Man kann das OBDH in drei Teile unterteilen. Auf der einen Seite gibt es die CDMU (Controlling DATA Main Unit), welche, schon wie der Name erahnen lässt, die Hauptsteuereinheit ist. Auf der anderen die RTU (Remote Control Unit), welche die Steuerung des Datenfluss des Mainbus übernimmt, und der Mainbus selbst.

Das RFS ist die Sende- und Empfangseinheit eines Satelliten, welche Daten in

Form von Telecommands von der Erde empfängt und z.B. Telemetrydaten zur

Erde schickt.

Um eine Verbindung zur Erde zu realisieren, werden zwei Arten von Antennen eingesetzt.

Zum eine gibt es die LowGain Antennen, die zur Übertragung der Daten in

Erdnähe benutzt werden (LEO-Orbit), und zum anderen die HighGain Antennen,

die eingesetzt werden, wenn sich der Satellit weit von der Erde entfernt befindet

(GEO-Orbit).

Die Temperaturregelung eines Satelliten wird vom TCS übernommen. Da ein

Satellit während seiner Mission teilweise extremen Temperaturschwankungen

ausgesetzt ist, ist es wichtig, dass die empfindlichen Bauteile eine relativ

konstante Temperatur besitzen.

Hierbei werden zwei Verfahren zum Schutz vor Hitze und Kälte eingesetzt.

Die passive Kühlung besteht aus einer Art Wärmeschutz, der den Satelliten

mit einer aufgetragenen Substanz vor der Hitze schützt. Um den Satelliten

vor der Kälte zu schützen, wird das aktive System benutzt. Es besteht

aus Heißelementen (Heater), die bestimmte Baugruppen bei zu geringer Temperatur

aufheizen.

Heutzutage gibt es eine Vielzahl von verschiedenen Satelliten, welch unterschiedlichen

Aufgabengebieten geordnet werden können.

Es gibt Wettersatelliten, anhand deren Bilder vorausgesagt werden kann, wie

sich das Wetter in den nächsten Tagen entwickelt. Des weiteren befinden

sich in einer geostationären Umlaufbahn Rundfunk- und Fernsehsatelliten,

die die Erde mit Fernsehprogrammen versorgen.

Das Benutzen von GPS – Systemen, die heutzutage einen immer wichtigeren

Stellenwert haben, ist nur durch Navigationssatelliten möglich.

Man könnte noch mehr Aufgaben von Satelliten beschreiben, was aber im Rahmen

dieser Ausarbeitung zu weit gehen und vom eigentlichen Thema ablenken würde.

Zwei Arten von Satelliten seien aber trotzdem etwas näher betrachtet: zum

einen die Fernerkundungssatelliten und zum anderen Spionagesatelliten.

Solang es die Menschheit gibt, gibt es auch Spionage, während sie sich

früher „nur“ darin äußerte, dass einzelne Person

(Spione) andere ausspionierten, werden heute Konzerne oder ganze Staaten überwacht.

Gerade zu Zeiten des „Kalten Krieges“ wurde die Spionage ein immer

wichtigeres Mittel, um alles über den Feind zu erfahren.

Mit der Zeit stieg die Gefahr, dass Spionage aufgedeckt wurde, und man musste

neue Wege beschreiten seinen Gegner zu bespitzeln. Also wurden auch Satelliten

eingesetzt, da sie viel schwerer zu entdecken waren, als beispielsweise die

U2 (ein amerikanisches Spionageflugzeug). Anfangs kamen Satelliten zum Einsatz,

die wegen ihrer geringen Flughöhe nach einigen Tagen in der Atmosphäre

verglühten. Bevor dies allerdings geschah wurden die belichteten Filme

zur Erde fallen gelassen. Vor dem Erreichen des Bodens wurden die Filme von

Flugzeugen abgefangen (siehe Bild). Heutzutage bleiben Spionagesatelliten längere

in einer Erdumlaufbahn, und ihre Daten werden auch nicht mehr mittels Fallschirmen

zur Erde geschickt, sondern über abhörsichere Kanäle.

Da es fast keine Daten über Spionagesatelliten gibt, will ich mich nicht

in Spekulationen verfangen. Die technische Entwicklung soll aber soweit sein,

dass die Satellitenbilder eine Auflösungen von 0.10 cm haben.

Abb. 1 Ein amerikanische Flug fängt einen Satellitenfilm ein

Während Spionagesatelliten einem rein militärischen Zweck dienen,

werden die Daten von Fernerkundungssatelliten kommerziell genutzt. Die Daten

können für die Gestaltung von neuen Straßen oder Städten

benutzt werden, oder dazu, rechtzeitig Gefahrenbereiche, in denen es z.B. zu

Überschwemmungen kommen kann, ausfindig zu machen. Sie werden aber auch

genutzt, um Kartenmaterial auf dem neuesten Stand zu halten oder zu überprüfen,

ob Bauer A. seine Felder so bestellt, wie er es beantragt hat.

Im Groben gibt es zwei Systeme, die für die Fernerkundung in Frage kommen.

Die Radarsatelliten senden Radarstrahlen zur Erde von der sie reflektiert werden,

und wieder am Satellit angelangen. Durch ein unterschiedliches Eintreffen der

Strahlen kann z.B. ein Höhenmodell erstellt werden. Zum anderen gibt es

optische Systeme, die Fotos von der Oberfläche schießen. Beide Systeme

haben für bestimmte Aufgabenbereiche ihre Vor- und Nachteile, aber einen

entscheidenden Nachteil haben die optischen Systeme. Während Radarsysteme

auch bei schlechtem Wetter ihre Arbeit fortsetzen können, können z.B.

Wolken optischen Systemen die Sicht nehmen.

Da es sich aber bei diesem Seminar um ein Multimedia bezogenes Seminar handelt,

werde ich im Folgenden nur auf optische Systeme eingehen. Um einen kleinen Überblick

über mögliche Auflösungen bei optischen Systemen zu geben, sollen

die folgenden drei Bilder dienen.

Abb. 2 Vergleich zwischen verschiedenen Satellitensystemen

Man kann auf den Bildern sehen, dass man auf dem Landsatbild eigentlich nicht viel erkennen kann, aber auf dem Ikonosbild schon viel mehr. Um einen Überblick über aktuelle Fernerkundungssatelliten zu geben, sollen im Folgenden die Systeme Spot, Ikonos und Quickbird dienen.

Am 22.2.1986 wurde mit Spot 1 der erste Satellit der Spotreihe in eine erdnahe Umlaufbahn gebracht. Das Spotprogramm sollte das erste kommerzielle Erderkundungssatellitenprogramm der Welt sein. Das war nicht ganz der Fall, da es sich bei dem Betreiber der Spotsatelliten, um eine Tochterfirma der französischen Raumfahrtorganisation CNES handelt. Es war geplant mit dem Verkauf der Satellitenbilder die laufenden Kosten und neue Satelliten zu finanzieren. Dieses Konzept ist bis heute nicht aufgegangen, so dass gerade einmal die laufenden Kosten mit den Verkäufen getilgt werden konnten.

Gegenüber früheren Erderkundungssatelliten wie z.B. der Landsatsatelliten, war Spot 1 mit CCD – Sensoren ausgestattet, was ihn wesentlich moderner machte.

Wie schon erwähnt startete Spot 1 am 22.02.1986. Ihm folgte am 22.1.1990

Spot 2 und am 26.9.1993 Spot 3.

Die ersten drei Spot-Satelliten besaßen in etwa die gleichen technischen

Eigenschaften. Sie waren mit einem 120 Gbit Bandrekorder ausgestattet, auf dem

ca. 280 unkomprimierte Bilder gespeichert werden konnten, bevor sie zur Erde

gesendet wurden.

Leider fielen die Bandrekorder nach einiger Zeit aus, so dass die Spotsatelliten

keine Bilder mehr zwischenspeichern konnten. Das führte dazu, dass sie

nur noch in bestimmten Gebieten Bilder aufzeichnen konnten, in deren Nähe

sich eine Bodenstation befand ( jede Bodenstation hat einen Empfangsradius von

etwa 1250 km, es gibt auf der gesamten Erde 23), da die Bilder direkt zur Erde

geschickt werden mussten. Trotz dieser Probleme sendeten Spot 1 und Spot 2 bis

1998 etwa sechs Millionen Bilder zur Erde. Nachdem das Lageregelungssystem von

Spot 3 im Jahre 1996 ausgefallen war, verglühte er in der Atmosphäre.

Die Satellitenbilder von Spot 1-3 können eine Auflösung von 6000

x 6000 Pixel ( multispektral ) oder 3000 x 3000 Pixel ( panchromatisch ) erreichen.

Das an Bord befindliche Weitwinkelteleskop hat einen Blickwinkel von 4 Grad

( das entspricht am Boden 60km). Es besitzt einen Durchmesser von 30 cm bei

einer Brennweite von 1.08m . Das Teleskop ist um 27 Grad seitlich schwenkbar,

was dazu führt, dass Spot Bereiche der Erde aufnehmen kann, die sich nicht

nur direkt unterhalb seiner Flugbahn befinden. Eine CCD Zeile besteht aus 6000

Elementen.

Spot 1-3 konnten Bilder mit einer Auflösung von 10m (panchromatisch) oder

20m (multispektral) aufzeichnen.

Spot 4 wurde am 24.04.1998 in seine Umlaufbahn gebracht. Durch die negativen

Erfahrungen die man mit den Bandrekordern von Spot 1-3 gesammelt hatte, wurden

bei Spot 4 mehrere RAM Speicher verwendet, die zusammen ca. 600 Bilder speichern

konnten.

Spot 4 war den vorangegangenen Spot – Satelliten sehr ähnlich. Trotzdem

hob sich die Spot 4 Mission durch einen Test hervor.

Da es um die Erde herum mittlerweile eine Vielzahl von Satelliten gibt, wird

es in nächster Zeit zu einem Datenstau über unseren Köpfen kommen.

Um dieses Problem rechtzeitig zu lösen, gibt es verschieden Ansätze,

die Datenmengen mit neuer Technik zu senden. Eine Überlegung geht dahin,

dass man Daten mittels einem Laserstrahl überträgt, da durch seine

Kurzwelligkeit in geringerer Zeit mehr Daten übertragen werden können.

Das ist aber nicht so einfach zu realisieren, da Satelliten wie z.B. Spot 4

sich immer nur eine kurze Zeit über einem bestimmten Gebiet auf der Erde

befinden. Um dieses Problem zu lösen, werden sogenannte Relaissatelliten

eingesetzt. Sie befinden sich meistens in einer geostationären Umlaufbahn

und werden für die Übertragung von großen Datenmengen benutzt

(Rundfunk und Fernsehen). Die Sendeleistung von Fernerkundungssatelliten ist

im Vergleich hingegen eher gering, sodass man „nur“ eine Verbindung

zwischen Fernerkundungs- und Relaissatelliten schaffen müsste, um die Übertragungsrate

zu erhöhen. Genau das wurde bei der experimentellen Laserlink-Kopplung

zwischen Spot 4 und Artemis getestet. Artemis ist ein Kommunikationssatellit,

der, nachdem er in einem falschen Orbit ausgesetzt wurde seine Zielposition

in einem geostationären Orbit nur mit viel Zeitverlust und dem Einsatz

seiner Thruster erreichen konnte. Trotz dieser Probleme von Artemis konnten

die Tests Ende 2002 gestartet werden. Die beste Übertragungsrate zwischen

Artemis und Spot 4 beträgt 50 Mbit\s was nicht unbedingt den Erwartungen

entspricht (mind. 100 Mbit\s), aber trotzdem den Erfolg dieser Test nicht wesentlich

schmälert.

Abb. 3 Laserlink zwischen den Satelliten Spot 4 und Artemis

Während sich die technischen Veränderungen zwischen Spot 1 und Spot

4 eher im Rahmen hielten, enthielt der am 04.05.2002 gestartete Spot 5 eine

Vielzahl von Neuerungen.

Gegenüber Spot 4 wurde die Instrumentierung weiter verbessert. Das Kamerasystem

von Spot 5 besteht nun aus drei Kamerasystemen, die in der Lage sind, in drei

Richtungen gleichzeitig aufzunehmen. Während, wie schon bei Spot 1-4, eines

senkrecht nach unten ausgerichtet ist, gibt es ein weiteres, welches nach vorne

(um 20°) und eines, das nach hinten (um 20°) schaut. Durch diese Ausrichtung

der Kamerasysteme ist es möglich, dreidimensionale Bilder der Erde zu erstellen.

Die Auflösung wurde auf 5 m im panchromatischen mode und 10 m im multispektral mode verbessert. Es ist auch möglich, panchromatische Bilder mit einer Auflösung von 2,5 m zu erstellen. Um dies zu erreichen, werden gleichzeitig zwei Aufnahmen mit je 5 m aufgenommen, die dann später mittels Computer in ein 2.5 m Bild umgewandelt werden.

Da die aufgenommenen Bilder eine größere Datenmenge gegenüber z.B. Spot 1 besitzen, werden sie, bevor sie mit 100 Mbaud zur Erde gesendet werden, komprimiert. An Bord von Spot 5 befindet sich ein 90 GBit RAM Speicher, auf dem die Daten zwischengespeichert werden können.

Spot 5 kann auch im Gegensatz zu Spot 4 nicht nur 2 Bilder gleichzeitig aufnehmen,

sondern 5. Von den 5 Bildern können max. gleichzeitig 3 gespeichert werden,

so dass die anderen beiden zur Erde übermittelt werden müssen.

Abb. 4 Zeichnung des Spot 5 Satelliten

Am 24.09.1999 wurde nach einigen Startschwierigkeiten (Startverschiebung vom

27.04.1999 auf den 24.09.1999) der erste rein kommerzielle Satellit in seine

Umlaufbahn gebracht. Ikonos wird von der Fa. SpaceIMAGING unterhalten. Bei Ikonos

scheint das Konzept aufzugehen, dass der Verkauf der Bilder die laufenden Kosten

deckt und neue Satelliten mitfinanziert.

Ikonos umkreist die Erde in einer Höhe von 680 km mit einer Geschwindigkeit

von 7 km\s. Sein Gewicht hat sich im Vergleich zu anderen Satelliten verringert

(ca. 755 kg).

Die Aufnahmetechnik wurde gegenüber Spot 5 verbessert. Ikonos hat eine

Auflösung von 1m panchromatisch und 4m multispektral. Seine Bildbreite

beträgt 13 km. Im multispektralen Modus gibt es 11 Helligkeitsbits und

im panchromatischem Modus nur 8.

Die Kanäle von Ikonos sind :

· panchromatischer Kanal : 450-900 nm

· blauer Kanal : 450-530 nm

· grüner Kanal : 520-610 nm

· roter Kanal : 640-720 nm

· naher IR Kanal : 770-880 nm

Von den Möglichkeiten der Aufnahmetechnik von Ikonos haben sich Journalisten

viel versprochen. Sie hofften mit den Aufnahmen endlich mit zu erleben, was

sich wirklich in Afghanistan und im Irak während dem Einsatz von US-Truppen

ereignete. Viele hofften, dass mit den Bildern, die Geheimhaltungstaktik der

Amerikaner diesbezüglich Risse bekommen könnte. Aber auch diese Möglichkeit

der Informationsfindung wurde vom Pentagon verhindert. Es wurden kurzer Hand

alle Bilder, die während der Konflikte in Afghanistan und im Irak aufgezeichnet

wurden, für ca. 2.000.000 US-Dollar pro Jahr gekauft, so dass eine Verbreitung

der Bilder unmöglich ist.

Abb. 5 Zeichnung des Ikonos Satelliten

Abb. 6 Satellitenbild von Ikonos ( Sydney , Auflösung 1m)

Am 18.10.2001 wurde Quickbird mit einer Delta Trägerrakete in eine Höhe

von 450 km gebracht. Nicht etwa eine verbesserte Technik ist für das gesteigerte

Auflösungsvermögen verantwortlich, sondern die geringe Flughöhe

von Quickbird. Da Quickbird etwa die gleiche Auflösung wie Ikonos gehabt

hätte, entschloss man sich ihn in einer geringeren Höhe zu bringen

um so doch noch bessere Bilder liefern zu können.

Quickbird nimmt Bilder mit einer Auflösung von 61 cm panchromatisch und

2,4 m multispektral auf. Ein Bild hat bei einer Szenengröße von 16.5

x 16.5 km eine Auflösung von 27,552 x 27,424 Pixeln panchromatisch und

6,888 x 6,856 Pixeln multispektral. Quickbird ist auch in der Lage sogenannte

„Strips“ aufzunehmen, d.h. Bilder mit einer Breite von 16.5 km und

einer Länge 165 km. Alle Kanäle haben 11 Bits für die Helligkeit.

· panchromatischer Kanal : 445-900 nm

· blauer Kanal : 450-520 nm

· grüner Kanal : 520-600 nm

· roter Kanal : 630-690 nm

· naher IR Kanal : 760-900 nm.

Die Bilder können auf einem 128 GBit großem Speicher abgelegt werden,

oder über das X-Band mit 320 Mbit\s zur Erde gesendet werden. Es ist geplant,

dass Quickbird sieben Jahre lang seine Arbeit verrichtet.

Quickbirdbilder, die Afghanistan und den Irak zeigen, wurden ebenfalls vom Pentagon

komplett aufgekauft, wie es schon bei den Bildern von Ikonos zuvor geschehen

ist.

Abb. 7 Zeichnung des Quickbirdsatelliten

Abb. 8 Satellitenbild von Quickbird (Hamburger Hafen, Auflösung 0.6 m)

Abb. 9 Das Hubble Space Teleskop

Im letzten Kapitel konnte man sehen wie die Erde vom Weltall aus beobachtet

wird, aber auch das Weltall selbst ist für den Menschen fast noch wichtiger.

Seit Menschengedenken hat das Weltall eine große Anziehungskraft, sodass

es viele Menschen gab, die sich mit seiner Erforschung beschäftigten. Während

Galileo fast für seine Behauptung, dass die Erde keine Scheibe sei, durch

die Inquisition hingerichtet wurde, ist es heutzutage einfacher, bestimmte Behauptungen

der Menschheit zu beweisen. Es gibt mittlerweile eine Vielzahl von Teleskopen,

die die Aufgabe haben, die letzten Geheimnisse des Weltalls zu lüften.

Wenn man die Vielzahl der auf der Erde befindlichen Teleskope sieht, stellt

man sich die Frage was da ein Milliarden teures Weltraumteleskop überhaupt

für einen Sinn macht. Aber die Antwort auf diese Frage ist ganz leicht:

jedes Teleskop das sich auf der Erde befindet hat immer ein Darstellungsproblem,

denn die Atmosphäre der Erde führt dazu, dass ein Flimmern eine 100

% Sicht auf Sterne oder Planeten verhindert. Auch Wolken und schlechtes Wetter

können die Sicht auf das Weltall einschränken.

Um diese, Probleme zu umgehen, wurde am 24. April 1990 das Hubble Space Teleskop

von der Raumfähre Discovery in seine etwa 600 km hohe Umlaufbahn gebracht.

Seit 1977 war ein Weltraumteleskop in der Planung, zunächst nur von der

NASA. Durch die damals schon sehr hohen Kosten von etwa 450 Millionen US Dollar

wurde die NASA aufgefordert, sich einen Partner zu suchen, der die Kosten mit

tragen sollte. So stieg ESA mit 15 % in das Vorhaben ein, was ihnen 15% der

Beobachtungszeit sicherte. Ob die ESA sich aber mit dem Wissen der endgültigen

Kosten an dem Unternehmen beteiligt hätte, ist wohl eher fraglich. Nachdem

sich Hubble im Weltall befand, waren die Kosten bereits auf 1,6 Milliarden Dollar

gestiegen.

Nach den ersten Testläufen war schnell klar, dass Hubble einen optischen

Fehler hatte, der nur mit einer Service Mission zu beheben war. Obwohl Hubble

nicht 100% einsatzfähig war, liefert es schon beeindruckende Bilder, die

alles bisher da gewesene übertrafen.

Das Hubble hat in etwa die Ausmaße eines Busses. Es ist 13,1 m lang,

hat einen Durchmesser von 4,3 m und wiegt etwa 11,6 t. Es wurde so entwickelt,

dass es möglichst viele astronomische Objekte ohne das Eingreifen des Menschen

beobachten kann. Es ist in der Lage so positioniert so werden, dass es 24 Stunden

lang ein Objekt beobachten kann. Das HST kann Licht in allen Wellenlängen

von infrarotem über sichtbares bis hin zu ultraviolettem Licht messen,

so dass man alle Arten von Objekten, die sich im Weltall befinden erforschen

kann. Man könnte mit dem HST ein Glühwürmchen sehen, dass sich

in 16.000 km Entfernung befinden würde.

Da das Hubble keine Steuerdüsen besitzt, und es von der Erde angezogen

wird, ist es notwendig, dass nach einem bestimmten Zeitraum ein Raumfahrzeug

das HST wieder in eine sichere Umlaufbahn bringt. Genau an diesem Punkt liegt

das momentane Problem des Hubble. Da seit dem Columbia-Unglück das Space

Shuttleprogramm eingefroren ist, ist es fraglich ob das HST vor dem Verglühen

in der Atmosphäre gerettet wird. Zum jetzigen Zeitpunkt ist noch nicht

über die Zukunft des Hubble entschieden.

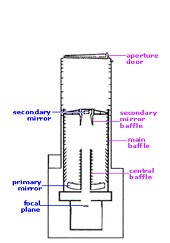

Abb. 10 Innenansicht vom Hubble

Der Tubus des Hubbles wird, wird von einer Schutzklappe geschützt, wenn es nicht benutzt wird. Wird diese Schutzklappe für eine Beobachtung geöffnet, wird das einfallende Licht von dem Streulicht durch die sogenannten Baffle geschützt. Die Baffle haben in etwa die gleichen Aufgaben, wie Eierpackungen an den Wänden eines Tonstudios, die alle störenden Schallwellen schlucken sollen. Das Licht trifft danach auf den Hauptspiegel (Durchmesser 2,7 m), bevor es von ihm reflektiert zum Sekundärspiegel ( Durchmesser 0,3m) gelangt. Auf dem Weg dorthin wird wieder Streulicht durch Baffle gefiltert. Nachdem es auf den sekundär Spiegel aufgetroffen ist, trifft das Licht nach dem Durchschreiten der Central Baffle auf die Instrumente, die das Licht auswerten.

Das Hubble kann nicht direkt mit der Erde kommunizieren. Es braucht einen Relaissatelliten

der das Hubblesignal zur Erde, oder die Signale von der Erde zum Hubble sendet.

Der Satellit sendet die Daten zur White Sand Test Facility, die die Daten dann

zum NASA Goddard Space Flight Center übermittelt. Das NASA Goddard Space

Flight Center ist im Schichtsystem 365 Tage, 24 Stunden im Jahr besetzt, um

das Hubble zu kontrollieren. Die Hauptaufgaben der Steuerung des HST übernimmt

das Space Telescope Operation Center, zu dem die Daten zum Schluss übermittelt

werden. Auch das Space Telescope Operation Center ist im 24 Stunden-Schichtdienst

besetzt.

Jeder hat die Möglichkeit eine Beobachtung mit dem Hubble zu beantragen.

Der Vorschlag wird von einem Gremium von Wissenschaftlern geprüft, und

wenn er für wichtig empfunden wird, bekommt der Vorschlag ein Beobachtungsfenster.

Bis heute hat es etliche Servicemissionen gegeben, die das Hubble repariert, gewartet oder verbessert haben. Mit dem HST wurden 330.000 Observationen an 25.000 Objekten durchgeführt, was zu einer geschätzten Datenmenge von 10 Terabyte führt.

Obwohl über die Zukunft des HST noch nicht entschieden ist, steht schon

das nächste Weltraumteleskop in den Startlöchern. Es soll für

noch bessere Bilder sorgen, und anders als das Hubble nicht um die Erde kreisen,

sondern sich zwischen der Sonne und der Erde aufhalten.

Im folgenden Kapitel soll es um die zur Zeit stattfindenden Marsmissionen der NASA und der ESA gehen. Der Mars soll sowohl aus der Luft als auch am Boden genauer erforscht werden. Die Hauptaufgabe hierbei besteht darin, nach früher vorhandenen Wasservorkommen zu suchen, die ein Leben auf dem Mars bestätigen würden. Es soll ein Überblick über die Aufgaben und Ziele der Missionen und speziell über die in Deutschland entwickelte High Resolution Stereo Camera (HRSC) der ESA gegeben werden.

Im letzten Sommer waren sich der Mars und die Erde so nahe wie schon seit langer

Zeit nicht mehr, was zu einem wahren „Run“ auf den Mars führte.

Durch die Nähe der Planeten war es möglich die Flugzeit einer Marsmission

erheblich zu verringern. Obwohl die Marsmissionen seit Jahren geplant wurden,

war der Druck sehr hoch, die Marssonden in dem nur ein paar Wochen großen

Zeitfenster zu starten. Gerade bei der NASA wurde der Start der zweiten Trägerrakete

wegen schlechter Startbedingungen mehrmals verschoben.

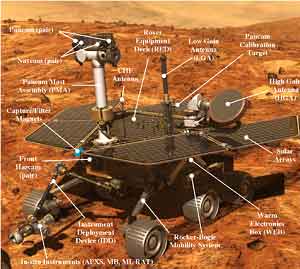

Abb. 11 NASA Marsrover

Abb. 12 ESA Marsexpress

Während den Ingeneuren der Vikingmissionen in den siebziger Jahren noch

ein Milliarden Budget zur Verfügung stand, steht ihren Kollegen der heutigen

beiden Marsmissionen nur ein Bruchteil dieses Betrages zur Verfügung. Dieser

Unterschied kommt aber nicht dadurch zustande, dass Technik heutzutage billiger

geworden ist, sondern vielmehr darin, das in der heutigen Zeit selbst die NASA

zum Sparen gezwungen ist. Man kann sagen, das die Ingeneure mit weniger finanziellen

Mitteln mehr erreichen müssen.

Die Planung der aktuellen amerikanischen Marsmission hat schon weit vor der

1997 gestarteten Pathfindermission begonnen. Wie man schon vom Namen Pathfinder

(zu deutsch Pfadfinder) ableiten kann, sollte diese Mission ein Probedurchlauf

für die aktuelle Marsmission sein. Man erhoffte sich, dass die bei der

Pathfindermission gewonnenen Daten für die Verbesserung der Marsrovermission

dienen könnten. Die gewonnenen Daten der Pathfindermission erleichterten

die Entwicklung der Marsrover um einiges, aber vieles bereitete den Ingeneuren

auch Probleme. So musste viel Zeit investiert werden, die Bremsfallschirme neu

zu konzipieren, da die Fallschirme der Pathfindermission nicht für das

gesteigerte Gewicht der neuen Marsrover ausreichten. Dieses und weitere kleine

und große Probleme, führten dazu, dass der Start der Mission um einige

Tage nach hinten verlegt werden musste.

Wie schon in den siebziger Jahren wurden auch diesmal gleichzeitig zwei Lander

zum Mars geschickt, die an gegenüberliegenden Landestellen ihre Arbeit

verrichteten. Spirit, der erste der beiden Rover ist im Gusev-Krater gelandet,

der ausgeprägte Spuren eines früheren Sees erkennen lässt. Sein

Zwillingsbruder Opportunity kam einige Tage später am so genannten Meridiani

Planum an, da auch dieses für die Wissenschaftler der NASA von großem

Interesse ist.

Kurz bevor die beiden Raumkapseln der Rover in die Marsatmosphäre eingedrungen

sind, hatten sie eine Geschwindigkeit von ca. Mach 31.5, die durch die enorme

Reibung beim Eintritt deutlich gesenkt wird. Damit die Raumkapsel trotz der

gefallenen Geschwindigkeit noch stärker abgebremst, wird müssen Bremsfallschirme

benutzt werden. Die von Airbags umschlossenen, Kapseln können noch bis

zu einem Kilometer springen und rollen, bevor sie endgültig zur Ruhe kommen.

Trotz aller Vorsichtsmaßnahmen ist das eine der gefährlichsten Passagen

der gesamten Mission, da die Airbags an Felsen platzen und die Rover so unkontrolliert

auf dem Mars einschlagen könnten. Wenn die Kapsel zum Stillstand gekommen

ist, wird automatisch die Luft aus den Airbags entlassen, und drei Abdeckungen

geben die beiden Rover frei. Nachdem die Rover ihre Betriebsbereitschaft erreicht

haben, können sie mit ihrer eigentlichen Arbeit beginnen und ein erstes

360° Panoramabild machen, damit die NASA ihren Standpunkt bestimmen kann.

Die beiden Rover ähneln im Aufbau sehr ihrem Vorgänger Sojourner

der Pathfinder-Mission. Da sie um einiges größer sind, erhöht

sich ihr Gewicht auf jeweils 185 Kilogramm. Sie sind in der Lage sich pro Marstag

theoretisch maximal 100 m weit zu bewegen. Sojourner legte im Gegensatz dazu

diese Entfernung während seiner gesamten Mission zurück.

Die Rover sind aber auch im Bezug auf die Sicherheit weiterentwickelt worden.

Da die NASA die Bilder vom Mars mit einer Zeitverzögerung von etwa 20 min

erhält, könnte es sein, dass die Rover auf einem Felsen feststecken,

bevor die NASA auf diese Situation reagieren kann. Aus diesem Grund ist die

Software der Rover in der Lage, selbstständig zu entscheiden, wie in bestimmten

Situationen reagiert werden soll. Wenn man also die Steuerung der Rover etwas

knapp beschreiben würde, könnte man sagen, dass die NASA die Untersuchungsziele

aussucht, und die Rover den Weg dorthin selbstständig finden.

Die Rover beziehen ihre Energie aus ihren Solarzellen, die am Tag durch die

Sonne aufgeladen werden. Falls die Zellen eines Rovers ausfallen sollten, wäre

die Mission für ihn beendet, da es sonst keine Möglichkeit der Energiegewinnung

an Bord der Rover gibt. Da die Rover extremen Temperaturschwankungen ausgesetzt

sind, werden bestimmte Aufgaben in der Nacht erfüllt, um mit der abgegebenen

Wärme bestimmter Instrumente die Rover zu wärmen. Würde man dies

nicht machen, würde die meiste Energie für das Warm-Halten von Spirit

und Opportunity verschwendet werden.

Wie man auf Abb.13 erkennen kann, besitzen beide Rover einen Kameramast, an

dem sich die verschiedensten Kamerasysteme befinden. Eine Kamera wird für

die Navigation benutzt, während zwei andere, die sich parallel zueinander

befinden, für drei dimensionale Panoramaaufnahmen benötigt werden.

An der Vorderseite befindet sich ein Instrumentenarm, der je nach Aufgabe verschiedene

Instrumentenköpfe benutzen kann. Das Wechseln dieser Köpfe wird automatisch

durchgeführt. Um einen kleinen Überblick über die Arbeiten der

Rover zu geben, werden im Folgenden drei Instrumente etwas näher beschrieben.

Abb. 13 Bezeichnung der Bestandteile eines Marsrovers

Beim Mini-TES handelt es sich um ein Instrument, das die emittierte Wärmestrahlung von z.B. Gesteinsbrocken misst und analysiert. Durch dieses Verfahren wird die Zusammensetzung von Gesteinsbrocken und dem Marsboden genauer untersucht. Es kann also festgestellt werden, ob sich Kohlenstoffe, Silikate, organische Moleküle und durch Wasser geformte Mineralien auf dem Mars befinden. Es wird Infrarotstrahlung benutzt, da sie in der Lage ist, auch durch Marsstaub bedeckte Objekte zu untersuchen. Durch die Messung der Wärmestrahlung sind die Wissenschaftler auf der Erde in der Lage, hochauflösende Temperaturprofile zu erstellen, oder genauere Aussagen über die Wärmespeicherkapazität von auf dem Mars befindlichen Gesteinen und Böden zu machen.

Mit dem sogenannten Microscopic Imager können Nahaufnahmen von Gesteinen

und dem Marsboden gemacht werden, da es sich bei diesem Instrument um eine Kombination

aus Mikroskop und Kamera handelt.

Um ein Schwarzweißbild mit der Größe von neun Quadratzentimetern

( drei Zentimeter Kantenlänge) zu machen, muss der Microscopic Imager bis

auf sechs Zentimeter an das zu untersuchende Objekt heran gebracht werden. Der

Microscopic Imager wird benutzt um von unter Wasser geformtes Sedimentgestein

zu finden, was beweisen würde, dass es auf dem Mars früher Wasser

gegeben hat. Auch Verformungen des Gesteins aufgrund vulkanischer Aktivitäten

oder durch Asteroideneinschläge können mit Hilfe des Microscopic Imager

entdeckt werden.

Um mit dem Mössbauer-Spektrometer arbeiten zu können, muss es mit

der zu untersuchenden Probe direkt in Kontakt gebracht werden. Da das Spektrometer

für eine Messung eine Messdauer von mindestens zwölf Stunden benötigt,

wird es wie oben beschrieben häufig nachts eingesetzt, um die Rover zu

wärmen.

Mit dem Mössbauer-Spektrometer soll das Vorhandensein und die Zusammensetzung

von eisenhaltigen Mineralien gemessen werden, da die wichtigsten Mineralien

auf dem Mars Eisen enthalten und Informationen über die früheren auf

dem Mars befindlichen Umweltbedingungen geben können. Des weiteren ist

das Mössbauer-Spektrometer in der Lage festzustellen, welche magnetischen

Eigenschaften untersuchte Objekte besitzen und ob sie möglicherweise fossile

Spuren von Lebensformen enthalten könnten.

Auch die ESA setzt auf die Technik eines Mössbauer-Spektrometers, da im

Lander Beagle2 ein an der UNI Mainz entwickeltes eingebaut wurde.

An Bord von Spirit und Opportunity befindet sich eine 25 Mhz starke PowerPC-CPU

mit 32 Bit vom Typ RAD6000 (RISC-Architektur), mit einem 128 DRAM großem

Arbeitsspeicher und einem 3 MB großen EEPROM. Die PowerPC Platform wurde

nach AIM 1991 spezifiziert. AIM ist die Abkürzung für ein Konsortium

aus Apple, IBM und Motorola. PowerPC-Prozessoren beherrschen Fließkommazahlen

doppelter und einfacher Genauigkeit und arbeiten im Big Endian-Modus. Es gibt

aber auch einzelne Prozessormodelle, die alternativ in den Little Endian-Modus

umschalten können.

Man kann PowerPC-Prozessoren z.B. in Apple-Macintosh-Rechnern, in Embedded Systemen

und im Nintendo GameCube finden.

Wenn man sich die Taktrate von 25 Mhz ansieht, wird man sich fragen, ob diese

nicht etwas gering ist angesichts von heutigen Prozessoren mit 3 Ghz,. Da man

nur eine begrenzte Energie zur Verfügung hat, kann man keine Energie verzehrenden

Prozessoren (z.B. Intels P IV) in die Rover einbauen, wenn ein etwas optimierter

Chip mit 25 Mhz vollkommen ausreichend ist.

Die Rover besitzen auch ein Betriebssystem, und zwar handelt es sich hierbei

um VxWorks der Firma Wind River. VxWorks ist ein Echtzeitbetriebssystem, d.h.

dass das Betriebssystem zusätzliche Echtzeit-Funktionen für die Einhaltung

von Zeitbedingungen und die Vorhersagbarkeit des Prozessverhaltens einsetzt.

VxWorks wird aber nicht nur im Weltall eingesetzt, sondern findet auch Zuspruch

in Embedded-Systemen, in der industriellen Fertigung (z.B. bei der Steuerung

von Fertigungsrobotern) und sogar in der Formel1

Während die NASA ihre Hauptaufgaben mit ihren beiden Mars-Rovern auf dem Mars direkt erledigt, ist bei der ESA die Aufgabenteilung in zwei Bereiche unterteilt. Da währe zum einen die Raumsonde Marsexpress, die mit Hilfe der HRSC die Marsoberfläche aufnimmt, und zum anderen der Marslander Beagle, der auf der Marsoberfläche verschieden Experimente durchführt.

Abb. 14 ESA Marslander Beagle2

Nach einigen Problemen mit Marsexpress musste die ESA vor einigen Wochen, auch

die

Beagle - Mission für gescheitert erklären. Seit dem Abkoppeln von

Beagle von der Raumsonde sei kein Kontakt mehr zustande gekommen, und es sei

eine unabhängige Kommission ins Leben gerufen, die klären soll, wie

es zu diesem Problem gekommen ist. Trotz verschiedener Rettungsversuche habe

sich Beagle nicht einmal gemeldet, und es sei unklar wo sich Beagle momentan

befindet.

Wenn man die Marsmission der NASA und der ESA vergleicht, sieht man, dass die

NASA in bestimmten Bereichen einen sicheren Weg eingeschlagen hat. Das bedeutet

aber nicht, dass die ESA nicht genau genug war, sondern dass die NASA durch

ihre Pathfinder-Mission gewisse Vorteile hatte.

So sendeten z.B. die beiden Rover an bestimmten Abschnitten ihrer Eintrittsphase

in die Marsoberfläche Kontrollsignale, damit die NASA genau wusste, in

welcher genauen Phase sich die Rover befinden. Dieses Verfahren schützte

die Rover nicht vor einem Absturz, es kann aber die Fehleranalyse entscheidend

erleichtern, wenn man genau weiß, in welcher Phase ein Fehler aufgetreten

ist.

Obwohl Beagle von der ESA als verloren angesehen wird, soll trotzdem auf seine Aufgaben eingegangen werden.

Etwa fünf Tage bevor die Sonde Mars Express am Mars eintrifft, wird Beagle2

von ihr abgekoppelt und setzt seine Reise zur Oberfläche alleine fort.

Der Eintritts- und Landevorgang hat in etwa den gleichen Ablauf wie der Mars

Exploration Rover.

Bei den Hauptzielen des in England entwickelten Beagle2 handelt es sich um biochemische

und biologische Untersuchungen auf der Marsoberfläche. Um diese Ziele zu

erreichen, besitzt Beagle2 verschiedene Komponenten, z.B. den Robotarm oder

den sogenannten Maulwurf.

Am Robotarm befinden sich alle Instrumente und verschiedene Kameras. Es gibt

drei Kameras, wovon zwei dazu genutzt werden, Panoramaaufnahmen der Oberfläche

zu machen (im Stereoverfahren). Die dritte Kamera, die Teil eines Mikroskops

ist, wird genutzt, die Beschaffenheit von Felsen etwas genauer zu untersuchen.

Am Robotarm befindet sich aber auch das Grinder and Corer System, das Felsen

für die Untersuchungen reinigen soll und in der Lage ist, ein etwa einen

Zentimeter tiefes Loch in einen Felsen zu bohren, um cirka 60 Milligramm schwere

Proben aus dem Inneren zu erhalten.

Der Maulwurf, auch Pluto (Planetary Undersurface Tool) genannt, kann dank eines

Federmechanismus den Aktionsradius von Beagle 2 um etwa drei Meter erhöhen.

Da Beagle2 eine geringe Größe besitzt, wurde auf Antennen verzichtet,

die in der Lage wären die Bilder und Messergebnisse direkt zur Erde zu

senden. Aus diesem Grund braucht Beagle2 immer eine Relaisstation für den

Datentransport. Normalerweise übernimmt Mars Express diese Aufgabe, aber

da sich die Sonde nicht permanent in einer geeigneten Position befindet, weicht

die ESA auf die amerikanische Sonde Mars Odyssey aus, die sich auch in einer

Umlaufbahn um den Mars befindet.

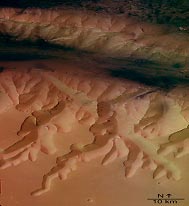

Abb. 15 Aufnahme der HRSC vom Mars

Im folgendem Kapitel wird die an der FU Berlin entwickelte High Resolution Stereo Camera behandelt. Dabei sollen folgende Fragen beantwortet werden: Was ist eine High Resolution Stereo Camera? Welche Aufgaben hat sie und wie funktioniert sie?

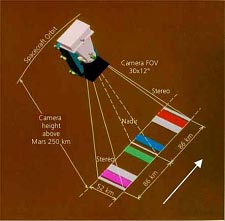

Man kann Marsexpress und die darin befindlichen HSRC mit einem Erderkundungssatellit

vergleichen, da sie im Prinzip die gleichen Aufgaben haben. Wie schon Spot5

ist auch die HRSC Kamera in der Lage, einen Geländebereich aus verschiedenen

Blickwinkeln aufzunehmen, sodass man am Ende eine dreidimensionale Karte vom

Mars erhält. Die Hauptaufgabe von der HSRC besteht also darin eine Landkarte

vom Mars zu erstellen.

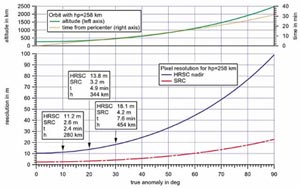

Tab.1 Abhängigkeit der Auflösung von der Flughöhe der HRSC

Die High Resolution Stereo Camera ist aber nicht speziell für die Mars Expressmission entwickelt worden, sondern sie sollte schon in der 93 Marsmission von Russland zum Einsatz kommen. Nachdem es aber Probleme mit dem Start der damaligen Trägerrakete gab, und die finanziellen Mittel zu Ende gingen, wurde das Projekt bis heute auf Eis gelegt. High Resolution Stereo Cameras werden aber nicht nur in der Raumfahrt eingesetzt. Es gibt eigens HRSC die nur auf der Erde ihre Anwendungsbereiche haben. So werden sie z.B. in Flugzeugen eingebaut, um 3D Karten von z.B. Deutschland zu erstellen.

Da sich Marsexpress in einer elliptischen Bahn um den Mars bewegt, ist die

Auflösung von 10m pro Pixel nur für einen bestimmten Zeitraum möglich,

nämlich dann, wenn sich die Sonde sehr nah am Mars befindet (ca. 250 km

über der Marsoberfläche). Je weiter sich Marsexpress vom Mars entfernt,

umso gröber wird auch die Auflösung der Bilder. Marsexpress ist dadurch

nur 40 min bei einer Umrundung in der Lage, Bilder vom Mars aufzuzeichnen.

Der Mars-entfernteste-Punkt wird dazu genutzt, Daten zur Erde zu senden und

die Batterien der Sonde wieder zu laden.

Abb. 16. Umlaufbahn von Marsexpress

Ursprünglich war von der ESA geplant, 50 % der Oberfläche des Mars mit

einer Auflösung von 15m/Pixel und 100% der Oberfläche mit 30m/Pixel

aufzunehmen. Dieser Plan konnte aber nicht eingehalten werden, da 30% der Energieleistung

durch einen Defekt in einer Solarzelle dauerhaft fehlte. Die Ingeneure der ESA

und der HSRC waren also gezwungen, den Energieverbrauch der gesamten Sonde zu

senken.

Auch die Auflösung der Bilder musste geändert werden, um Strom zu sparen.

Aus diesem Grund sollen 50% der Oberfläche mit 10-20m/Pixel, 75% mit 40m/Pixel

und 100% mit 100m/Pixel aufgenommen werden. Trotz dieser Einschränkung ist

der Einsatz der HSRC ein Erfolg.

Abb. 17 Bauteile der HRSC

Die HRSC besteht aus vier Komponenten, der HRSC Linse (Nr 1. Abb 17), der SRC

Linse (Nr. 2 Abb 17), der eigentlichen Aufnahmetechnik und der Digitaleinheit

(Nr3. Abb. 17).

Der SRC (Super Resolution Channel ) wurde unter anderem von Karl Zeiss entwickelt

und soll bestimmte Bereiche der Marsoberfläche mit einer Auflösung

von 2.3m/Pixel aufnehmen. SRC wird auch als Lupe bezeichnet, da er bestimmte

Bereiche hochauflösenden aufnehmen kann. Der SRC kann entweder permanent

der HRSC, nur an bestimmte Punkte oder in bestimmten Intervallen zugeschaltet

werden. Dabei ist immer bekannt, welche Daten von der HRSC oder vom SRC aufgenommen

wurden.

Die Digitaleinheit (Nr. 4 Abb. 17) besteht aus fünf Teilen, dem Kamera

Kontroll Processor, der Datenkompressionselektronik, dem Interface Electronics,

der Energieversorgung und der Wärmekontrollelektronik die im Folgenden

näher beschrieben sind.

Der Kamera Kontroll Processor ist die zentrale Kontrolleinheit für das

gesamte Kamerasystem. Im Kamera Kontroll Prozessor werden die Kontrolldaten

und die Telekommands der Raumsonde bearbeitet.

Der CCP besteht aus einem 80C86 Prozessor, ein boot PROM, einem EEPROM sowie

RAM.

Der 80C86 ist eine 16 Bit CMOS CPU mit einer Taktrate von 5Mhz. Da sich ein

EEPROM mit beliebigen Daten beschreiben lässt und auch wieder gelöscht

werden kann, wird er eingesetzt, um während der Mission Veränderungen

der Software möglich zu machen.

Ein Microcontroller und vier Kompressionseinheiten sind die Hauptbestandteile

der Datenkompressionselektronik. Die Kamera besitzt vier Signalleitungen, die

mit dem Input Speicher der Kompressionseinheiten verbunden sind.

Wenn die Daten von der Kamera zu den Kompressionseinheiten kommen, werden sie

in einem Puffer zwischengespeichert, bevor sie von Microcontrolern im JPEG Format

komprimiert werden. Nachdem die Daten in den einzelnen DC´s komprimiert

wurden, wird ein paralleler Datenstrom aus den 4fach parallelen Daten erzeugt.

Ein Microcontroller vom Typ 80C31 übernimmt die Erzeugung des seriellen

Datenstroms und die Einstellung der Kompressionsrate.

Die IFE besteht aus zwei Boards:

Die IFE01 beinhaltet die Schnittstellen niedriger Datenrate zwischen Kamerakopf,

Datenkompressionselektronik, dem Raumfahrzeug und dem Kamera Kontroll Prozessor.

Die IFE02 beherbergt die Schnittstellen für hohe Datenraten, die den Datentransfer

der wissenschaftlichen Bilddaten zum Massenspeicher gewährleisten.

Die Digitaleinheit und der Kamerakopf werden vom Energiesystem mit genügend Energie versorgt. Ein Energieumwandler in der Digitaleinheit sorgt für die Energie des SRC.

Das Kamerasystem ist wärmetechnisch von der Sonde isoliert. Um den thermischen Zustand der Kamera zu kontrollieren, wird das Heizsystem eingesetzt. Kühlstreifen und Radiatoren leiten die von der Kamera abgegebene Energie nach außen. Gleichzeitig heizen sechs unabhängige Heizspiralen in der optischen Bank und in den „front end electronics“ die Kamera auf etwa Raumtemperatur (ca. 20 Grad) auf. Die thermale Kontrolle wird unabhängig von der Elektronik der Kamera betrieben.

Die HRSC nimmt ihre Umgebung mit neun einzelnen CCD-Zeilen auf. Es wird nicht wie bei einer handelsüblichen Digitalkamera immer ein ganzer Bereich aufgezeichnet, sondern Zeile für Zeile. Vier der neun Zeilen sind für die Aufnahme der Spektralbereiche gedacht, und 5 für die Stereo-Aufzeichnungen.

Die HRSC nimmt die Marsoberfläche in verschiedenen Bereichen des sichtbaren Lichts auf. Das geschieht in den Bereichen Rot (750+/-20nm), Grün (530+/-45nm) und Blau (440+/-45nm). Dazu sind unterschiedliche Farbfilter vor den entsprechenden CCD-Zeilen montiert. Wenn man diese Farbdaten bei der Bildbearbeitung übereinander legt, ergibt sich aus der Mischung die Farbe, die von der Kamera auf dem Marsboden gesehen wurde. Eine weitere Zeile nimmt die Oberfläche im nahe Infrarotbereich (970+/-45nm) auf.

Die fünf übrigen CCD-Zeilen sind für die Stereoaufnahmen zuständig.

Eine Zeile nimmt den Bereich auf, der sich genau senkrecht unter der Raumsonde

befindet. Zwei weitere schauen in Flugrichtung nach vorn und zwei nach hinten.

Dadurch wird jedes Objekt, das auf dem Mars aufgenommen wird, aus fünf

unterschiedlichen Blickwinkeln aufgezeichnet, so dass auf der Erde aus diesen

Daten ein 3D Modell der Oberfläche zusammengesetzt werden kann. Die äußersten

beiden Zeilen nehmen die Landschaft in einem Winkel von +18.9° bzw. –18.9°

auf.

Die Zeilen dazwischen haben einen etwas geringeren Winkel.

Eine CCD-Zeile besteht aus 5184 Pixeln. Wenn sich die Raumsonde in einer Höhe von 250 km befindet, nimmt eine CCD-Zeile einen Streifen mit einer Breite von 52 km auf. Die gesamte Länge die von den neun Zeilen abgedeckt wird, beträgt 172 km.

Der SRC nimmt die Marsoberfläche nimmt nicht mit einem Zeilensensor, sondern

mit einem Flächesensor auf. Der verwendete Flächensensor hat eine

Größe von 1024x1032 Pixeln, und deckt bei einer Flughöhe von

250 km einen quadratischen Bereich von 2.35 x 2.35 km ab.

Dieses Bild zeigt die Anordnung der 9 einzelnen CCD-Zeilen. Die vier farbig

dargestellten Zeilen nehmen Spektralbereiche von rot, grün, blau und den

jenseits von rot liegenden nahen Infrarotbereich auf. Die fünf weiß

dargestellten Streifen entsprechen den Stereo- und Photometriekanälen.

Abb. 18 CCD-Zeilen der HRSC

Die Bilddaten der HRSC und SRC werden an Bord reduziert und komprimiert, bevor

sie zur Erde gesendet werden. Dabei kommen zwei Verfahren zum Einsatz, die Pixelsummierung

und die JPEG basierende Datenkomprimierung.

Bei der Pixelsummierung werden aus benachbarten Pixel Durchschnittswerte gebildet.

So bleibt bei einer 1x1 Pixelsummierung die volle Auflösung erhalten, und

bei einer 2x2 Pixelsummierung wird der Datenstrom vier mal kleiner. Bei der

2x2 Summierung werden immer vier Pixel zusammen gefasst. Das entspricht einem

quadratischem Bereich mit einer Kantenlänge von zwei Pixeln. Außer

die 1x1 und die 2x2 Summierung kommen auch noch die 4x4 und die 8x8 Pixelsummierung

zum Einsatz.

Bei der Datenkomprimierung nach dem JPEG-Verfahren wurde nach umfangreichen

Tests der Kompressionsfaktor auf einen variablen Wert zwischen vier und zehn

festgelegt. Dadurch wird eine auf verschiedene Bildeigenschaften zugeschnittene

Reduktion des Datenaufkommens bei akzeptablen Qualitätsverlusten ermöglicht.

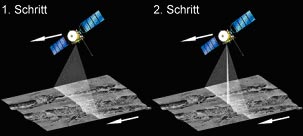

Abb. 19 Aufnahmetechnik der HRSC (Teil1)

Die HRSC fliegt an Bord der Sonde über die Marsoberfläche und nimmt diese Zeile für Zeile auf. Man könnte das Vorgehen mit einem Scanner vergleichen, da das zu scannende Blatt auch Zeile für Zeile aufzeichnet.

Die SRC kann zugeschaltet werden und nimmt dann innerhalb des Gesichtsfelds der Zeile sehr hochauflösende Detailaufnahmen auf. Dem Kamerasystem ist dabei immer genau bekannt, welche Pixel zur HRSC und welche zur SRC gehören. HRSC liefert also den räumlichen Kontext zu den SRC-Aufnahmen.

Abb. 19 Aufnahmetechnik der HRSC (Teil2)

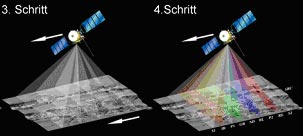

In diesem Schritt werden vier weitere Zeilen dazu geschaltet, wovon zwei nach vorne und zwei nach hinten schauen. Dadurch wird jedes Objekt aus fünf Blickrichtungen aufgezeichnet. Anhand dieser Informationen kann der Computer später ein digitales Höhenmodell erstellen.

Zum Schluss werden vier weitere Zeilen aktiviert, vor denen die verschiedenen

Farbfilter montiert sind. Insgesamt wird die Marsoberfläche mit neun Zeilen

abgescannt.

„Der Weltraum – unendliche Weiten“. Diese wohl jedem bekannte

Aussage einer berühmten Fernsehserie kann ich nur zustimmen, nach dem ich

einige Zeit in verschiedenen Quellen nach Material gesucht habe. Es kommt einem

am Anfang so vor, als würde man ständig auf einem schmalen Seil zwischen

dem Mond und der Erde balancieren immer in Gefahr sich in Nichtigkeiten zu verlaufen.

Wenn man dann nach einiger Zeit einen scheinbaren Anfang gefunden hat scheitert

man oft an der dürftigen Ausbeute seines Streifzuges durch die Welt der

Bücher und des Internet.

Irgendwann ist man an dem Punkt angelangt, an dem man nicht mehr zurück

kann, und man versucht aus den dürftigen Informationen das beste heraus

zu ziehen. Und plötzlich passiert es, man füllt Seite für Seite

mit Informationen über die verschiedensten Bereiche der Technik und Wissenschaft.

Und die Fragen die einen schon seit einiger Zeit beschäftigen finden im

gewissen Maße eine Antwort. Wann werden wir den Mars besiedeln, schaut

der große Bruder wirklich auf uns herab und was ist ein schwarzes Loch.

Auf all diese Fragen kann man eine Antwort finden, wenn man sich etwas näher

mit dem Thema „Multimedia im Weltall“ beschäftig. Obwohl der

Name dieses Seminar meiner Meinung nach nicht so glücklich gewählt

ist, kann man trotzdem viel bei der Ausarbeitung lernen.

Wenn man z.B. Hollywoodfilme sieht, könnte man denken das jeder Schritt

von uns aus dem Weltall genau beobachtet wird, und man bekommt ein bedrückendes

Gefühl in der Magengegend. Dabei sieht die Wirklichkeit nicht ganz so düster

aus. Es ist schon im gewissem Maße möglich aus dem Weltall beobachtet

zu werden, aber mir ist kein heutiges Satellitensystem bekann was die nötige

Auflösung hat um einzelne Personen zu identifizieren. Da ist die Gefahr

von Überwachungskameras in Einkaufsstrassen oder Geschäften aufgezeichnet

zu werden viel greifbarer.

Auch auf die Frage ob es jemals Leben auf dem Mars gegeben hat, und ob eventuell

durch einen Asteroidencrash das leben vom Mars auf die Erde gekommen ist, kann

ich bis jetzt noch nicht eindeutig beantworten. Aber es spricht schon viel dafür,

angesichts das der Mars die Schießscheibe unseres Sonnensystems ist. Und

ob der Strafe Zeitplan der Amerikaner zur Besiedelung des Mars eingehalten werden

kann, wage ich doch zu bezweifeln. Aber wir haben ja auch schon eine Mondlandung

gesehen, die bis heute noch umstritten ist.

Wenn ich an meine Kindheit zurück denke, an den „Kalten Krieg“

läuft mir schon ein Schauer über den Rücken, aber wo wäre

die Raumfahrt heute, wenn es diesen Abschnitt der jüngsten Geschichte nicht

gegeben hätten. Fragen über fragen die hoffentlich in den nächsten

Jahren eine Antwort finden. Abschließend kann ich nur noch sagen, dass

es doch Spaß gemacht hat dieses Seminar zu halten, trotz der ganzen Probleme

in den Anfängen.